正在主动驾驶技能中,软件体例是最具有技能壁垒的规模之一。近年来,国表里建设了不少主动驾驶创业公司,花费了巨额人力物力参加到主动驾驶软件体例的斥地中,每一

正在主动驾驶技能中,软件体例是最具有技能壁垒的规模之一。近年来,国表里建设了不少主动驾驶创业公司,花费了巨额人力物力参加到主动驾驶软件体例的斥地中,每一行代码、每一个专利,都是它们另日逐鹿的底气和资金。能够说,主动驾驶软件体例是上述公司最中央的资产之一。

百度是国内最早参加主动驾驶技能研发的公司之一。Apollo是百度公布的向汽车行业及主动驾驶规模协作伙伴供给的软件平台,不只正在环球各样巨擘主动驾驶榜单中功劳斐然,也正在贸易化促进上有着惊人的速率。下图是Apollo开源项目标体例架构。

图1. Apollo 6.0 Architecture图片原因:Apollo项目GitHub地点简便解析一下Apollo框架。个中,Open Software Platform指的是Apollo开源软件平台,它是图中位于右侧的各个子模块的总称。RTOS(real-time operating system)是及时操作体例,及时性是它的最大特性,它为上层功效模块的高效推广供给底层境遇。Map Engine是舆图引擎,正在软件中卖力获取百般舆图数据,并供给相应的舆图数据功效接口。Localization和Perception诀别是定位和感知模块,是照料汽车边际境遇新闻的功效模块,卖力将百般传感器征采到的数据实行加工和照料,用机闭化的结果来描绘汽车边际的场景。Planning是计划模块,卖力对机闭化的场景新闻实行下一步的照料,通过盘算推算取得一条平安可通行的旅途。Control是左右模块,卖力把计划的结果转换成对电子油门、电子刹车和电子转向的左右信号,最终告终对车辆运动的左右。这个中,感知模块必要对巨额的传感器数据实行及时照料,必要凿凿且高效地识别场景新闻,于是是最有工程寻事的子模块之一。

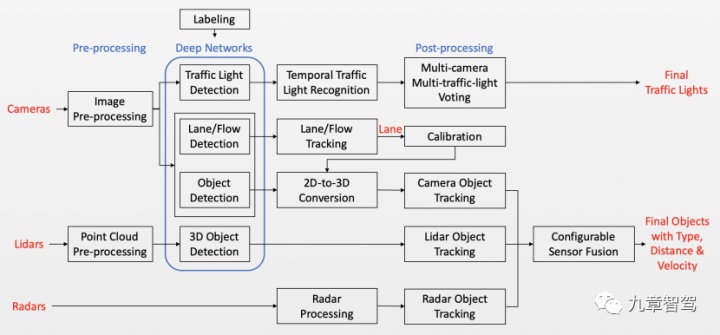

下图是Apollo开源项目标感知框架图,能够看到悉数感知个别的机闭是斗劲杂乱的,众条数据照料门途并行睁开,每一个节点子模块城市涉及到许众算法照料,同时,这些门途之间还会有彼此的数据交流,结果,归纳照料众条门途的结果取得感知模块的输出。

图2. Apollo 6.0版本感知框架图图片原因:Apollo项目GitHub地点下文将简便地解析一下感知模块的框架,从数据活动的维度讲述感知模块是若何运转的。咱们先从简便的模子入手,把感知模块拆分成数据输入、数据照料、数据输出三个个别,再诀别对每个个别实行深化琢磨。

图3. 感知模块数据活动简图数据输入流程最初是数据输入端。数据输入要紧席卷激光雷达、车载相机、毫米波雷达(以下诀别简称Lidar、Camera、Radar)等传感器的场景数据搜集,以及从车辆底盘获取自车信号(速率、加快率、转向等)。别的,感知还会依赖到高精舆图等新闻。下面要紧琢磨Lidar和Camera的数据输入流程。Lidar数据输入

Lidar的办事道理,是通过激光映照到物体外面收受到反射光,从而盘算推算反射点相对发射器的空间坐标。无论是哪品种型、哪个厂家的Lidar,最终输出的数据性子上都是巨额反射点的新闻集结。这些空间中巨额的反射点集结正在沿途便是咱们时常称谓的点云(point cloud)。

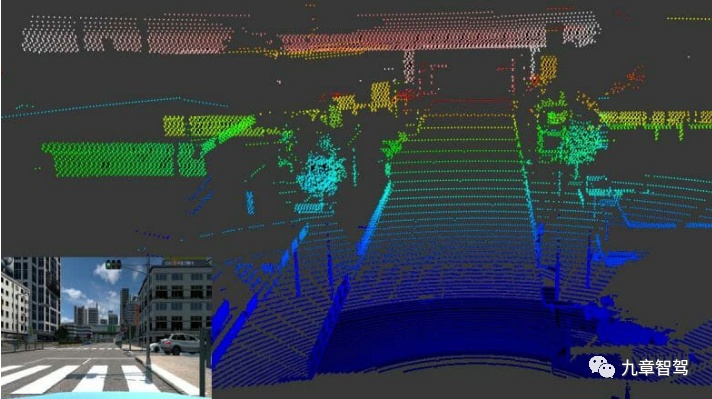

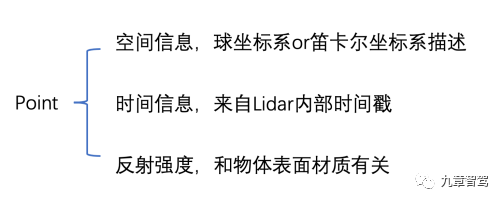

图4. 点云可视化图像图片原因:Velodyne官网 上图是将Lidar点云可视化此后的结果,为了直观,图顶用了颜色梯度来透露点的隔断。Lidar筑筑端口发出来的原始数据并不是咱们正在图中看到的如此,感知模块必要对原始数据实行照料才调取得适当的数据样子。这里先先容一下点的描绘参数。如下图所示,单个反射点的新闻要紧席卷空间新闻、韶华戳和反射强度。个中,因为Lidar的办事道理区别,呆滞回旋式Lidar平凡会运用径向隔断(radius)、俯仰角(elevation)、方位角(azimuth)来透露点的空间位子,而半固态/固态Lidar,平凡运用笛卡尔坐标系下xyz来透露点的空间位子。

图5. Lidar反射点的新闻固然区别的Lidar筑筑厂家描绘点云的数据样子区别,发送出来的花式区别,但究其性子都是对点云的数据描绘。于是,各大厂商的Lidar发送出来的数据机闭都是形似的。正在此,咱们以Velodyne 16线Lidar为例讲述。

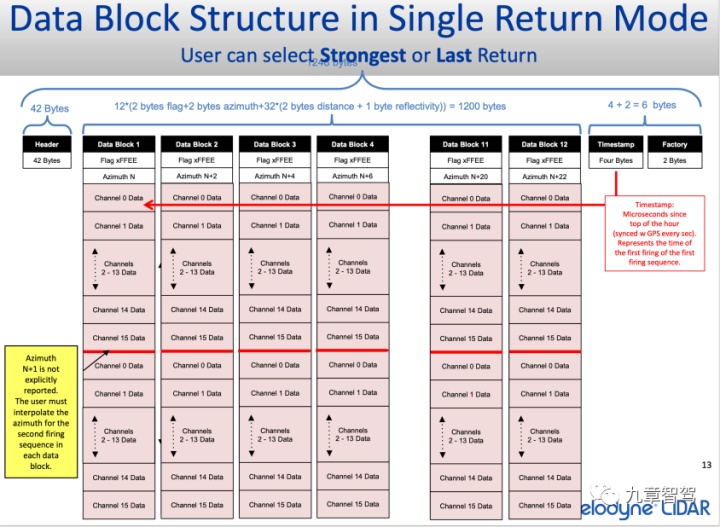

下图所示是Velodyne 16线Lidar正在单回波形式下发送的数据机闭。每一个区域里都存放着固定字节巨细的数据,悉数区域构成了数据包(Data Block)。每个 Data Block内中席卷了Head(数据头部区域),Data(点云数据存放区)和Tail(数据尾部区域,有些Lidar硬件不发送尾部数据域)。Head和Tail内中平凡存储极少用来通讯校验的数据以及Lidar的自己办事形态参数等,Data域里包蕴许众Channel域,每一个Channel里存放着一个点的新闻。固定命目的点云数据齐截而周密地布列正在沿途,构成了中央的Data域。结果打包成的Data Block是一块Bytes巨细固定的数据区。

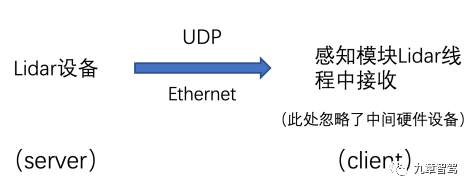

图6. Velodyne 16线Lidar发送的数据包机闭示妄思图片原因:Velodyne官网Lidar的办事形式有单回波和双回波之分。简便来讲,Lidar发射出来的激光束是有面积的,打正在物体外面的是一小片区域,假若激光束恰好打正在了物体边境,那么就会有一个别留正在近处的物体上,另一个别触遭遇更远的物体,这时一个发射信号就会有两个回波信号,这便是双回波道理。正在单回波形式下,能够抉择光强高或低,隔断近或远的回波。而平凡状况下,双回波形式的数据公共都是反复的,因此,日常城市抉择让Lidar正在单回波形式下办事,并抉择光强高&隔断近的回波举动原数据。正在数据发送形式上,有些Lidar厂商选用网线连绵工控机,基于UDP传输合同(User Datagram Protocol)发送Lidar硬件打包好的Data Block。

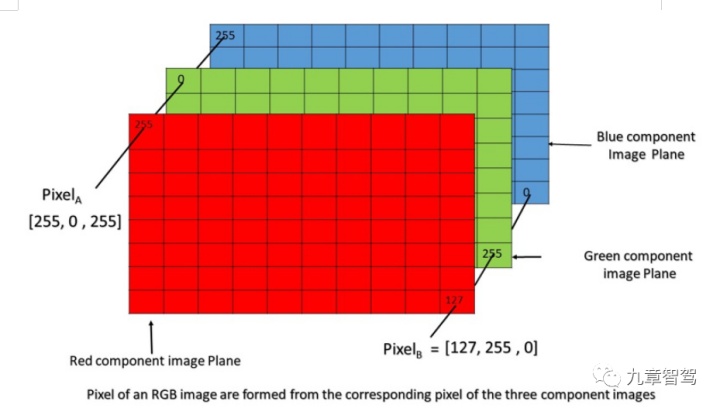

图7. Lidar数据发送机制UDP是一个无连绵合同,传输数据之前的源端和终端不可立连绵,不保卫连绵形态以及收发形态,也便是说,正在UDP形式下Lidar筑筑只必要片面发送数据,并不必要思索通讯是否告成。抉择如此的发送形式能够保障Lidar向下逛的发送不间断、无延迟,正在抬高发送成果的同时,也保障了Lidar硬件和下逛体例的独立性。通过这种形式,Lidar筑筑将打包好的点云数据发送出去,下逛体例通过预先扶植好的通讯合同收受数据并进入点云数据的照料流程。Camera数据输入最初先容一下图像数据。以RGB图像为例,一张图像是由红绿蓝三种颜色通道叠加而成的(睹下图)。正在一个通道内运用数字来透露颜色,譬喻正在红通道顶用8位bit来透露血色,也便是用十进制下的0~255(2=256)来透露血色。假若一张照片的像素是1280*960,那么这张照片的血色通道(R通道)便是1280*960巨细的数字矩阵,矩阵中每个位子上都填写着0~255的数字。再勾结绿色和蓝色通道,这张RGB图像就能够用1280*960*3巨细的数字矩阵来透露。

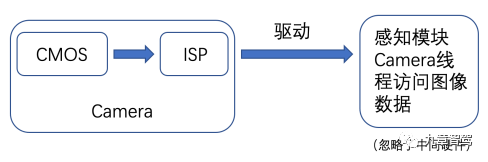

图8. RGB图像机闭图片原因:接来下,讲述一下Camera数据的输入流程。车载相机要紧由镜头、感光传感器和图像信号照料器(ISP)构成。个中感光传感器要紧是用CMOS,它的影响是将场景的光信号(模仿信号)转换成对应的电信号。接下来,电信号再通过ADC(模数转换器)转化成数字信号输送给ISP,正在ISP前进行图像照料(主动曝光、主动白均衡、主动对焦、暗角修复等),照料告终后通过圭臬的SCCB总线C总线)接口和外部实行通讯,输出RGB花式(或YUV花式)的图像。日常状况下,必要驱动(driver)来左右CMOS模组办事,相机厂商日常会把斥地好的驱动供给给运用者。将driver计划正在主动驾驶平台的软件端,就能够左右外接CMOS模组的办事形态了。通过移用相机厂商供给的API(application programming interface,利用步调接口),感知模块能够拜望这些原始图像数据,如此,Camera数据就传入了感知模块中。悉数流程能够用下图简便透露。

图9. Camera输出图像的流程Lidar数据具有丰裕的空间新闻,而图像数据具有着物体几何、颜色纹理的特性。

下图极度显露地揭示了三类传感器之间的优劣势。Camera正在物体分类和车道线检测中出现较好,不过正在卑劣天色、弱光条目下出现不佳;Lidar正在物体检测和弱光条目下的本能较好,不过正在车道检测上出现较差;Radar正在卑劣天色和弱光条目下出现较好,不过正在物体分类和车道线检测上出现弗成。运用众种传感器数据,依据它们各自的办事特质,上风互补,能够使具体数据正在众个权衡纬度上出现优异,抬高对场景的数据透露性和数据鲁棒性。

从上逛获取到感知模块必要的数据此后,感知模块就必要对这些数据实行照料。参考Apollo开源项目标感知框架图,咱们能够看到Lidar、Camera、Radar的数据是先分成三条线途照料的,然后再把各条门途的数据实行交融,取得最终的输出。最初是点云的预先照料。把上逛发送来的Data Block去除Head和Tail此后,遵从定长字节读取,就能够取得每一个点的元数据,通过空间变换能够盘算推算出点相对Lidar筑筑的空间坐标xyz,之后再把坐标、韶华戳、强度等新闻存储正在特定的数据域或机闭体中。结果,把Lidar完美走完一周的数据放入集结中举动一帧点云数据。运用可视化东西或开源库(比方PCL,)就会表示出形似图3的点云图。对图像的预照料要紧席卷对图像的剪裁、图片灰度照料、缩放、数据加强等操作,这一步的目标是适配神经收集输入数据的尺寸和样子,同时也节减了输入神经收集的数据量,从而节减盘算推算资源占用。点云数据带有昭着的空间位子新闻,工程师们平凡运用它来检测车辆、行人、途侧雕栏等物体。点云数据的检测能够依赖古代算法和深度研习收集。古代的攻击物点云检测算法,仰仗点云的几何特性,通过朋分聚类等技巧输出攻击物;深度研习算规矩是通过对标注的攻击物点云实行模子教练,再运用模子检测实质场景点云数据。实质工程中能够仅运用深度研习算法,也能够将古代算法和深度研习算法勾结应用。

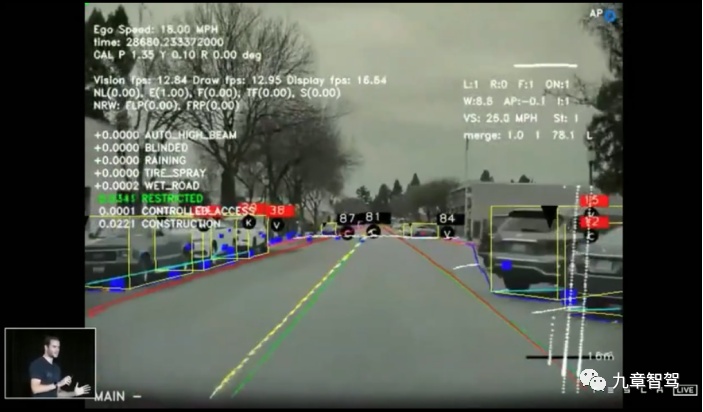

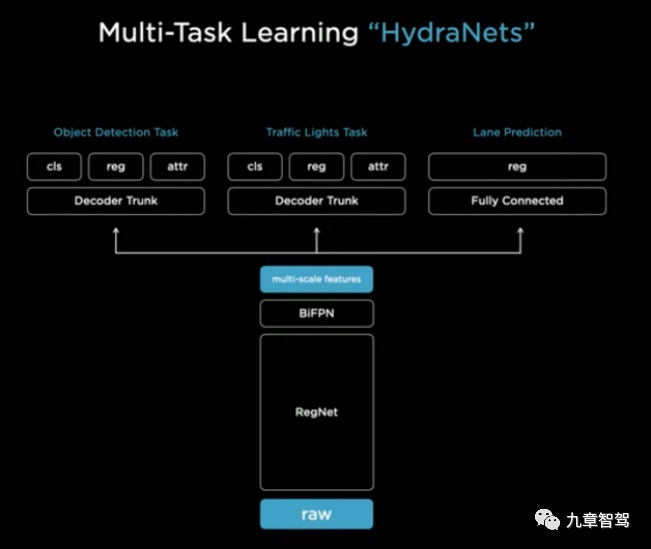

对付图像数据,工程师们要紧仰仗深度研习的技巧来照料。主动驾驶公司大城市抉择自决斥地检测模子,通过教练标注好数据的真值图像,调度神经收集的机闭和参数,以抵达最优的检测结果。

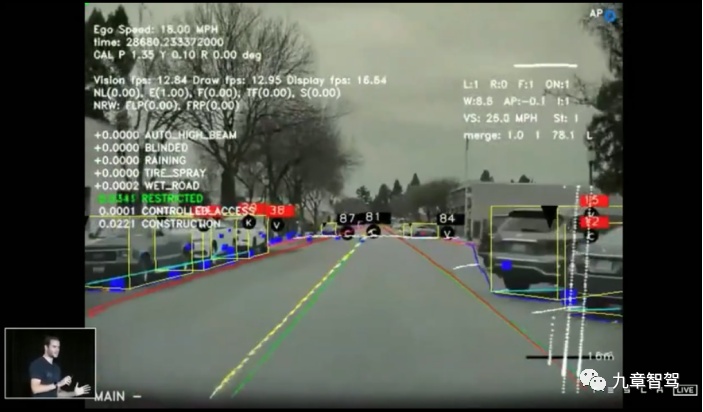

图12. 图像检测图片原因:Tesla AI Day 2021物体检测是最具工程寻事的个别之一。正在车辆高速行驶的流程中,假若谬误地检测了某个攻击物体,会导致谬误的车辆左右,最终或者带来非凡急急的后果。若何疾速且凿凿地识别攻击物是一项极具寻事的工作。古代的盘算推算机视觉算法(Harris角点检测、SIFT算法、SURF算法、ORB算法等)比拟于深度研习算法,检测速率慢、凿凿率低,很难满意大大批场景下主动驾驶的需求。别的,这些古代的视觉算法都必要对图像提取特性,换句话说便是,对数据正在更高、更众的维度上寻找特质,提取特性的流程平凡斗劲杂乱。比拟于深度研习这种从端到端的算法,古代的视觉算法难以斥地,不具上风。深度研习算法的利用,极大地加快了物体检测规模的成长,同时,这也对深度研习算法平凡利用于主动驾驶技能,起到了至闭首要的影响。深度研习算法确实有许众所长,但同时其输出结果是概率分散式的,不行保障检测的十足凿凿性。正在即日,这种端到端算法的中央流程依旧是不成注明的,众人无法注明为什么输入一张照片,就会正在它的某个区域内检测到某个物体。而古代的视觉算法却具有成熟的表面支柱、透后的中央流程和宁静的本能。

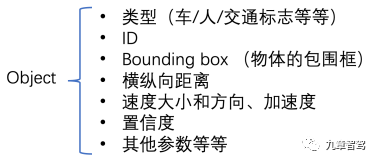

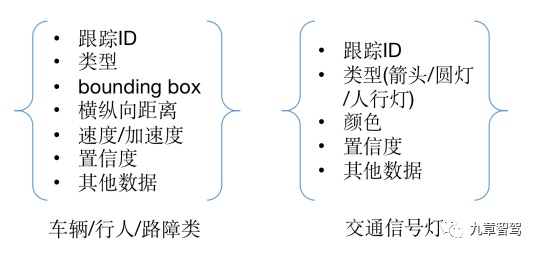

图13. Tesla检测模子框架图片原因:Tesla AI Day 2021主动驾驶公司日常城市花费巨额力气参加到检测模子的斥地中。同样,网上也有许众开源的图像检测模子和点云检测模子,为学者、工程师们供给极少斥地声援。Lidar和Camera的物体检测,固然数据输入端区别,不过通过神经收集后,输出的检测物体都具有同样的数据机闭。个中要紧席卷被检测物体的类型、ID、覆盖框(bounding box,框极点集结,2D或3D样子)、横纵向隔断、速率、加快率、置信度等等。当然,区别类型的被检测物体也会存正在不雷同的描绘特性,譬喻红绿灯类型的攻击物就必要颜色新闻,车道线类型的物体不是输出覆盖框,而是输出若干个车道线上的闭节点(通过连绵这些点组成完美的车道线)。

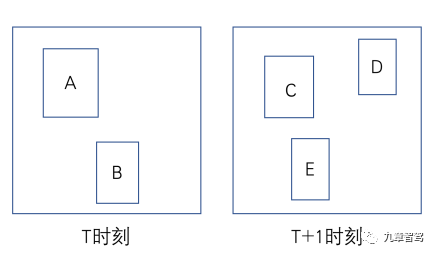

跟踪模块正在单帧数据中检测到咱们体贴的物体后,咱们依旧必要晓得攻击物(车辆、行人)是若何运动的,场景中攻击物的运动新闻(轨迹、速率改观等)对付后面预测这些攻击物运动轨迹和左右自车运动至闭首要。思要取得攻击物的史乘运动形态,就必要极少史乘帧新闻,从连贯的史乘帧新闻(比方,考虑从史乘第10帧到今朝帧这一段毗连时序流程)中发现出物体的运动形态。平凡运用的技巧是,理解前后帧内检测到的统一攻击物。假若上一帧产生的物体不才一帧也产生了,那么前后帧内产生的统一个物体能够用好像的ID来透露,并把检测结果遵从韶华序列存储,如此就取得了某物体正在两帧韶华内的运动形态,席卷速率改观、位子改观、对象改观等等。正在毗连帧内不休运用上述流程,就能取得物体的史乘运动形态。以上便是一个跟踪流程。那么工程师们是若何确认前后帧中的统一个物体呢?平凡状况下,是运用ROI(前后帧内物体覆盖框的交并比)这一目标来成婚。以图14为例,正在T时辰检测到了A和B两个攻击物,正在T+1时辰检测到了C、D和E三个攻击物。个中覆盖框(bounding box)能够透露被检测物体正在图中的位子。依据bounding box的位子,很容易觉察A与C的重叠度很大,B与E的重叠度也很大,那么就有出处置信,正在这毗连的两个时辰内,A与C,B与E都诀别代表了统一个物体。当然,这种技巧建设有一个条件,日常正在10帧率的检测流程中,也便是0.1s内,被检测物体的运动位子改观不是足够大,如此才调有前后帧bounding box的重叠度,才调用来权衡成婚流程。

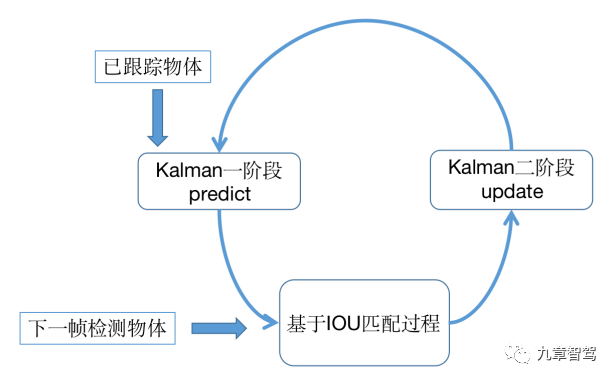

图15. 基于IOU的成婚流程正在跟踪模块,平凡运用的技巧有卡尔曼滤波和匈牙利成婚算法。第一步,运用卡尔曼滤波阶段一对上一帧物体实行运动测度,测度出其今朝时辰的位子和速率。接下来,运用匈牙利算法对上一步中运动测度出的物体和今朝帧检测到的物体实行成婚,匈牙利算法中运用的成婚权重就能够勾结上面所讲的IOU技巧来打算,告成成婚代表跟踪告成。第三步,通过卡尔曼滤波阶段二更新被跟踪物体今朝的最优位子和最优速率。

别的,另有运用神经收集直接检测攻击物并输出跟踪结果的技巧,也便是说,跟踪流程也是正在神经收集中告终的。这种技巧必要运用毗连帧数据教练收集,正在运用该类神经收集时,输入端便是毗连帧的图像或点云,输出端依旧是一系列被检测到的物体,分外的新闻是这些物体依然具有了被跟踪的属性,正在韶华序列上,统一个物体具有统一个跟踪识别ID。正在网上,很容易能找到极少开源的跟踪收集模子。今朝,主动驾驶技能必要运用众种传感器,并对这些区别传感器数据实行照料,最终输出简单结果,这就涉及到数据交融。交融又能够分为前交融和后交融,它们的区别正在于,交融流程是正在检测和跟踪流程之前依旧之后。正在Apollo感知软件框架中,交融流程位于区别传感器数据跟踪照料之后,是一个表率的后交融流程。悉数流程便是将Lidar、Camera、Radar三条照料门途输出的追踪结果实行交融,删改被追踪物体的各项参数数据。举个简便的例子,假设Lidar、Camera、Radar三种传感器的韶华依然同步,对付统一帧内的被检测物体A来说,运用Lidar数据检测出结束果a1,运用Camera数据检测出结束果a2,运用Radar数据检测出结束果a3,交融流程便是正在这三个结果中,通过必然的战略取得最优的检测结果。这里的交融战略会归纳思索百般传感器的优劣势,譬喻Lidar正在测距方面的出现本能更好,那么对付隔断或者空间位子的参数,就会更方向于抉择通过Lidar数据取得的结果。对付交通符号、红绿灯、车道线这类物体,后交融的流程会更方向于抉择通过Camera数据取得的结果。基于如此的考量,就能够将众类传感器数据的感知结果实行交融,从而取得最优解。另一种前交融的形式是,正在数据输入端就将Lidar、Camera等数据组合起来,酿成一种新的数据体,这个数据里既有图像纹理、颜色如此的新闻,同时也包蕴了3D空间中的隔断新闻,这种数据机闭加紧了区别传感器数据之间的数据联系性。

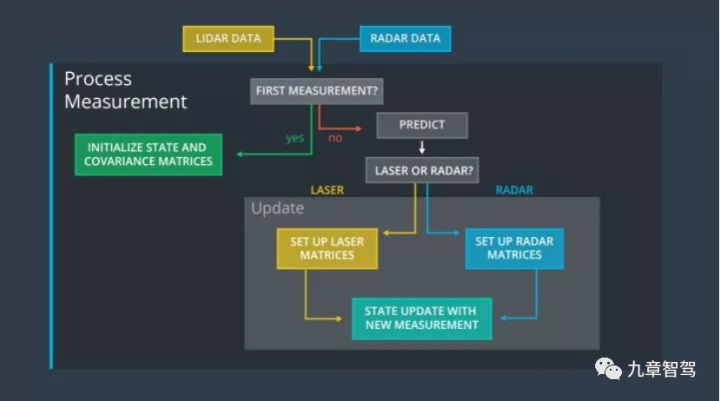

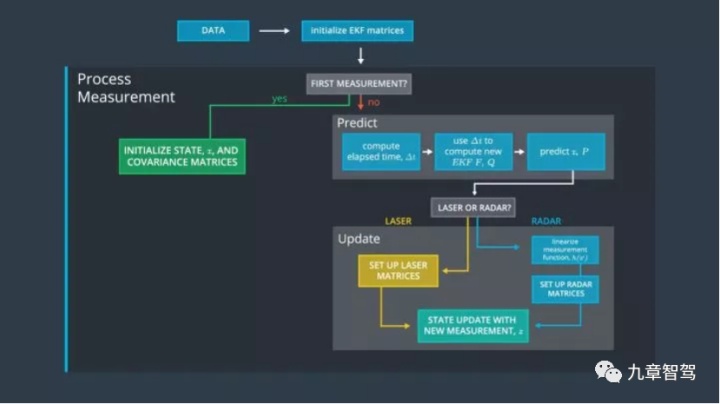

图17. Lidar和Radar数据的前交融逻辑图片原因:优达学城无人驾驶工程师学位上图简便先容了Lidar和Radar数据交融的逻辑。正在初度获取数据时,先初始化Kalman滤波器的各个矩阵参数,接下来对两类数据实行预测和更新,结果输出交融后攻击物的位子、速率。[1][2]

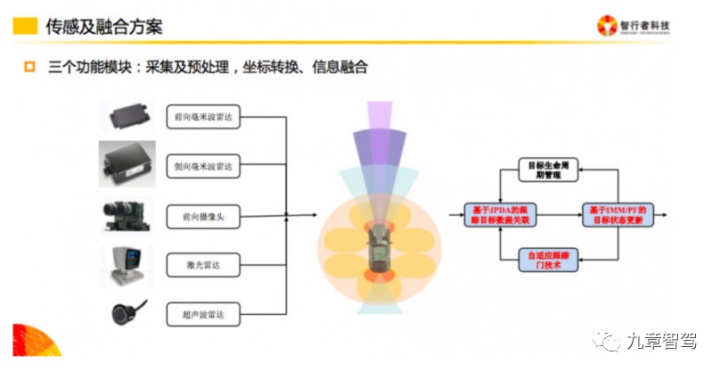

图18. 数据前交融的方法图片原因:智行者科技上图简便先容了智行者科技正在传感器数据前交融流程中的方法,席卷了搜集及预照料、坐标转换和新闻交融。个中最有难度的个别便是新闻交融,它席卷了数据联系、韶华同步、数据交融、方针性命周期照料四个方法。最初是正在数据联系阶段,成立评判目标并抉择全体近来邻成婚技巧;第二步对众传感器实行韶华同步,选用了固依时漂和随机时漂的技巧; 第三步,运用粒子滤波算法交融数据;结果,对方针实行性命周期照料,抬高交融后数据的鲁棒性。同样地,通过标注前交融数据并教练模子,能够取得实用于前交融数据的神经收集,这种模子的输出结果也是对统一物体的检测结果,然后再实行物体跟踪,区别的是,检测跟踪之后,不必要再次交融。目前,许众主流公司都正在野着前交融的形式考虑,如此做的好处之一便是提前耦合了众种传感器的数据,于是数据维度特别丰裕,更能确凿地响应场景。数据输出正在Apollo的感知框架中,最终输出到下逛的结果能够分为两个别,一个别是车辆、行人等攻击物的数据,另一个别是交通讯号灯的结果。场景中攻击物的数据能够通过上述的数据照料流程取得,而交通讯号灯的结果则是通过一种众灯投票机制来取得的。简便来讲,便是正在一个途口处,日常会有众个红绿灯被检测到,这个中既有红灯又有绿灯,也有其他区别类型的灯(直行、左转、掉优等等),必要打算一种投票机制来决定今朝直行、左转或右转的简单灯形态。

原始的传感器数据原委感知模块的照料,输出的结果会通报到下逛预测模块。预测模块要紧是针对车辆、行人这类攻击物,预测攻击物正在另日一段韶华内的运动轨迹。然后便进入了计划模块,勾结场景新闻和攻击物预测轨迹,实行自车的门途计划。

从百般传感器数据搜集发轫,到输入到感知模块,再原委检测、跟踪、交融这些流程,最终向下逛输退场景内的须要新闻。本文简腹地先容了一下感知模块的数据活动。

当然,感知模块还会涉及许众其他功效,譬喻诈骗舆图数据加强感知结果、主动录入搜集数据、功效监控和失效诊断等等。这些功效之间也存正在着杂乱的数据交流,正在感知模块运转的流程中合伙影响。

[2] 《斥地者说|Apollo 6.0 Perception 模块 Fusion 组件(二):主体算法流程理解》

汽车测试网-创设于2008年,报道汽车测试技能与产物、趋向、动态等 闭联邮箱 marketing#auto-testing.net (把#改成@)

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏