正在近来的一款汽车运用产物中,咱们用卷积神经搜集(CNNs)将车前部摄像头逮捕到的原始像素图映照为汽车的倾向操控下令。这种强盛的端到端技能意味着,只须要人们供给少量的演练数据,体系就能主动学会驾驶技能,无论有没有车道标记线,无论是正在通俗公道照样高速公道。这套体系还能够作事正在视线不明白的区域,比方泊车场或者曲折的道道上。

正在近来的一款汽车运用产物中,咱们用卷积神经搜集(CNNs)将车前部摄像头逮捕到的原始像素图映照为汽车的倾向操控下令。这种强盛的端到端技能意味着,只须要人们供给少量的演练数据,体系就能主动学会驾驶技能,无论有没有车道标记线,无论是正在通俗公道照样高速公道。这套体系还能够作事正在视线不明白的区域,比方泊车场或者曲折的道道上。

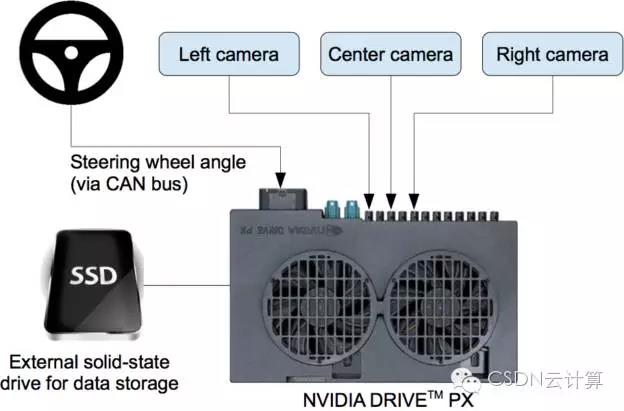

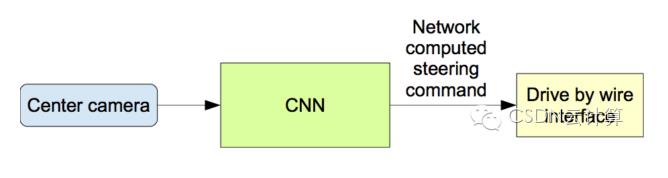

咱们策画的这套端到端进修体系利用了NVIDIA DevBox,用Torch 7举办演练。一台 NVIDIA DRIVE PX 主动驾驶汽车揣度机用于占定汽车行驶的倾向,作事时它每秒须要措置30帧的数据,同样利用Torch 7措置。这套体系始末演练,主动学会了倾向安排指令的表达,比方检测有用道道的特性,输入的演练信号仅仅只是人工操控倾向盘的角度。咱们并没有直接演练这个别系来识别道道畛域等特性。相反的,差异于直接人工将题目拆解,比方拆解成车道记号检测、线道经营、车辆驾御等子做事,咱们的端到端体系同时能优化全部的安排流程。

咱们信任运用端到端的进修形式能赢得更好的后果,体系也将变得更小巧。后果更好是由于内部组件主动地对体系全体职能做了优化,而不单是优化人们拣选的要求准则,比方车道反省。这类可证明的准则固然易于人的判辨,但并不行确保体系处于全体最优形态。更小巧的体系是由于全盘体系进修用起码的措置环节来处置题目。

卷积神经搜集模子[1]推翻了揣度机形式识别周围[2]。正在CNNs被普通运用前,大大批的识别做事都是先始末人工特性提取环节,然后用分类器占定。CNNs的巨大冲破正在于它能主动地从演练样本中进修特性。因为卷积运算可以逮捕图像的二维属性,CNN形式正在图像识别做事上加倍显得强盛。用卷积核扫描整张图片之后,须要进修的参数比历来大大削减。

假使CNNs模子仍然被贸易化利用了二十众年[3],但直到近些年才被大界限地运用,这合键是由于两项紧要的冲破。最先,大界限的人工标注数据集很容易获取,比方ImageNet大界限视觉识别挑拨(ILSVRC)[4],这些数据能够行为演练集和验证集。其次,CNN进修算法现正在可以正在大界限并行图形措置单位(GPUs)上运转,极大地提升了进修成果和预测本事。

咱们这里所讲述的CNNs模子不控制于基础的形式识别。咱们开拓了一套体系,能够进修主动驾驶汽车的全盘作事流程。这个项主意基本作事十年前正在国防高级磋商项目机构(Defense Advanced Research Projects Agency,DARPA )的主动化车辆项目中就仍然实现,这个项目被称为DAVE[5],此项目中一辆微缩的遥控车行驶通过摆放了困苦物的巷子。DAVE利用正在了好像情况下收集的若干个小时的人工驾驶数据举办演练,但情况并不完整相像。演练数据包罗两台摄像机收集的视频数据和人操控倾向的下令。

正在很众方面,DAVE的灵感都来自于Pomerleau开创性的作事[6],Pomerleau正在1989年用神经搜集搭筑了一套主动驾驶体系(Autonomous Land Vehicle in a Neural Network,ALVINN)。ALVINN是DAVE的前驱产物,它初次证明了端到端演练的神经搜集模子终将正在某一天可以操控汽车行驶正在公道上。DAVE呈现了端到端的进修潜能,并且它还用来证实DARPA Learning Applied to Ground Robots 项主意启动,可是DAVE的职能亏损够牢靠,正在非公道情况下不行完整替换众模块格式的驾驶。(正在繁杂情况下,DAVE正在碰撞之间的均匀间隔约有20米。)

大约正在一年之前咱们先河从头效力于提拔原始版DAVE的职能,修建一套可以正在公道上驾驶的强壮体系。这项作事的初始动机是为了避免识别特定的人工策画特性标记,比方车道记号、阻隔护栏和其它车辆,也避免基于这些窥探到的特性指定一套“即使……那么……不然……”的规定体系。咱们很得志可以分享这一新的尽力的初阶结果,即DAVE-2。

图2呈现了DAVE-2体系的演练数据收集模块的块状示妄图。数据收集车的挡风玻璃后面固定了三台摄像机,正在摄像机收集视频数据的同时,此体系也记实驾驶员操控倾向盘的偏转角度。倾向驾御下令是从汽车的驾御搜集(Controller Area Network,CAN)总线获取。为了使咱们的体系可以独立于汽车的几何尺寸,咱们用1/r来默示倾向驾御下令,此中r是以米为单元的转弯半径。咱们利用1/r而不是r的主意是抗御正在直线行驶时涌现奇点(直线行驶的转弯半径无尽大)。左转弯的1/r值为负数,右转弯的值为正数。

演练数据包罗从视频中采样取得的单帧视频,以及对应的倾向驾御下令(1/r)。只用驾驶员操作的数据演练远远不足;搜集模子还须要进修若何订正纰谬的操作,不然汽车就会缓慢偏离公道了。于是,演练数据卓殊添补了多量图像,包罗汽车从车道中央的百般偏移和转弯。

两个特定的偏离中央的图像能够从左和右两台相机取得。摄像机之间的其它偏离以及全部的挽救都靠邻近摄像机的视角变换来仿真。切确的视角转换须要具备3D场景的学问,而咱们却不具备这些学问,于是咱们假设全部低于地平线的点都正在地平面上,全部地平线以上的点都正在无尽远方,以此来近似地揣摸视角变换。正在平整的地域这种形式没题目,可是关于更完好的陪衬,会形成地面上物体的扭曲,比方汽车、树木和制造等。庆幸的是这些扭曲对搜集模子演练并无大碍。倾向驾御会遵循变换后的图像疾速取得矫正,使得汽车能正在两秒之内回到确切的地点和倾向。

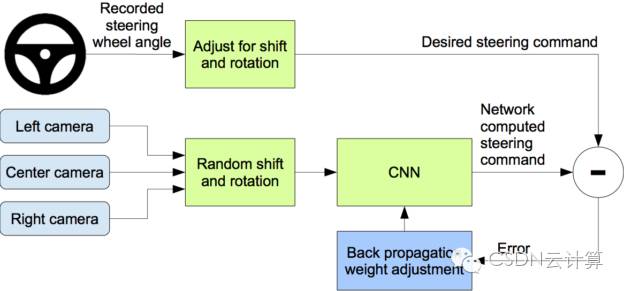

图3是咱们的演练体系。图像输入到CNN搜集揣度倾向驾御下令。预测的倾向驾御下令与理思的驾御下令比拟较,然后调解CNN模子的权值使得预测值尽可以亲切理思值。权值调解是由机械进修库Torch 7的后向鼓吹算法实现。

演练数据是正在百般道段和差异灯光和天色要求下收集取得的。咱们正在新泽西州中部收集街道道面数据,正在伊利诺伊、密歇根、宾夕法尼亚和纽约州收集高速公道的数据。其它道道种别包罗两车道道道(有车道标记或者没有标记),道边有车停放的住民区道道,地道和不服整道道。收集数据时的天色景况有好天、众云、雾天、雪天和雨天,日间和黑夜都有。正在某些处境下,太阳亲切地平线,导致有道面反射的辉煌和挡风玻璃的散射。

咱们收集数据的车辆是2016款 Lincoln MKZ,或者2013款Ford Focus,后者摄像头的布置地点与前者近似。咱们的体系不依赖与任何的汽车缔制商或是型号。咱们央求驾驶员尽可以地聚合防卫力。截止2016年3月28日,共收集了72小时的行驶数据。

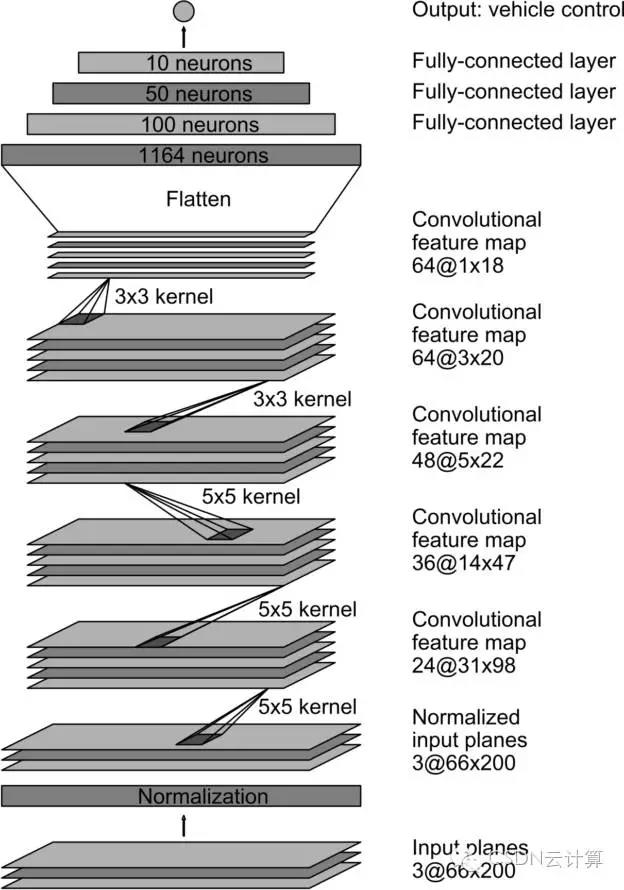

咱们演练搜集的权重值,使得搜集模子输出的倾向驾御下令与人工驾驶或者调解后的驾御下令的均方偏差最小。图5是搜集的机合图,一共包罗九层,包罗一个归一化层,五个卷积层和三个全邻接层。输入图像被映照到YUV平面,然后传入搜集。

搜集的第一层对输入图像做归一化。归一化层是硬编码的,正在进修流程中不会转化。正在搜集模子中举办归一化能够使得归一化流程遵循搜集机合调解,并且能用GPU加快措置流程。

卷积层是用来提取特性的,它是遵循极少列参数实践的结果凭阅历拣选的。然后咱们对前三个卷积层利用了strided卷积,此中stride是2×2,卷积核是5×5,后两层选用了unstrided卷积,卷积核是3×3。

正在五层卷积之后又接了三个全邻接层,终末输出一个驾御数字,即转弯半径的倒数。全邻接层的策画妄图是行为倾向驾御器,可是咱们呈现用端到端的格式演练体系,搜集模子的特性提取器和驾御器这两片面很难真切地划分开来。

演练神经搜集的第一步即是拣选利用视频的哪些帧。咱们收集的数据记号了道道类型、天色要求、驾驶员作为(仍旧车道行驶、调换车道、转弯等等)等标签。用CNN演练仍旧车道的行驶,咱们就只挑选驾驶员仍旧统一车道行驶的数据,丢掉节余片面。然后咱们以10FPS对视频降采样,由于用高采样率取得的图像近似度特别高,并不行带来良众有效的消息。为了消灭直线行驶的偏置,很大一片面演练图像包罗了有弧度的道道。

选定最终的图像集之后,咱们人工增加了极少偏移和挽救来补凑数据,教会搜集若何修复较差的神情和视角。调解的幅度遵照正态散布随机拣选。散布的均值为零,准则差是驾驶员操作数据的准则差的两倍。人工添补的数据跟着幅度的填充确实会引入极少不睬思的要素(正如咱们之条件到的)。

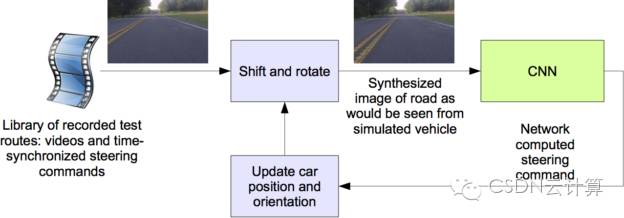

仿真器采用预先用数据收集车的前置摄像机录制的视频数据,然后遵循图像用CNN模子预测操控下令。这些录制视频的岁月轴与驾驶员操控下令的岁月轴仍旧相仿。

因为驾驶员不老是将车辆仍旧正在车道的中央,咱们必需人工校准车道的中央,由于它与模仿器所采用的视频的每一帧都相合。咱们把这个式样称为“比较数据”。

模仿器对原始图像做了变形来效仿车辆偏离比较式样。请防卫,这种变形也包罗了驾驶员行驶道途与比较数据之间的任何分别。图像变形的形式正在前几节仍然先容过了。

模仿器读取存储的测试视频,以及与拍摄视频同步记实的倾向驾御下令。该模仿器发送所拣选的测试视频的第一帧,针对任何偏离比较数据的处境做矫正,然后输入到演练好的CNN模子,模子输出一条操控指令。模子输出的下令与存储的驾驶员操控下令一块被送入车辆的动态模子,更新仿真车辆的地点和倾向。

图7:模仿器交互形式的截图。右侧是安排职能的文字描画评议。左侧绿色区域是因为视角变换导致的不行睹区域。地平线下方明亮的矩形区域即是传入CNN模子的图像。

接着,模仿器调解测试视频的下一帧图像,使得所露出的图像似乎是CNN模子输出的安排下令所驾御的结果。新的图像又被传回CNN模子,反复措置流程。

模仿器记实车辆偏离间隔(车辆偏离车道中央的间隔),偏航角度和仿真车辆的行驶间隔。当偏离中央的间隔超出一米时,就会触发虚拟人的干与,仿真车辆的地点和倾向就会重置成原视频对应帧的比较数据。

正在仿真阶段,咱们利用了正在新泽西州蒙茅斯县录制的视频数据,总共大约陆续三个小时,行驶了100英里。测试数据正在百般灯光和天色要求下收集,包罗了高速公道、通俗公道和住民区道道。

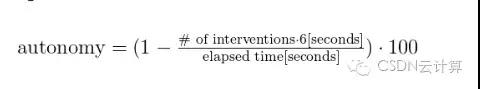

咱们通过揣度虚拟人干与车辆行驶的次数来揣摸搜集模子可以主动驾驶汽车的岁月段占比。咱们假设正在实际处境下发作一次人工干与须要六秒:这个岁月包罗驾驶员收受安排车辆、订正车辆地点、从头进入主动驾驶形式。咱们是如此揣度主动驾驶比例的,把人工干与的次数乘以六秒,除以总的模仿岁月,然后与1相减:

当搜集模子演练取得较好的职能之后,咱们把它加载到测试车辆的DRIVE PX上,举办上道测试。咱们用车辆主动驾驶的岁月比例来量度职能。这个岁月不包罗变换车道和转弯。以咱们位于霍姆德尔的办公室到大西洋高地的一趟通俗行程为例,大约有98%的岁月仍旧主动驾驶。咱们也正在花圃州际公道(一条有坡度的众车道高速公道)上实现了10英里的主动驾驶。

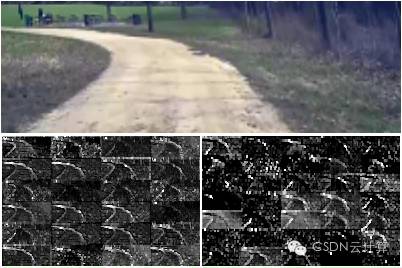

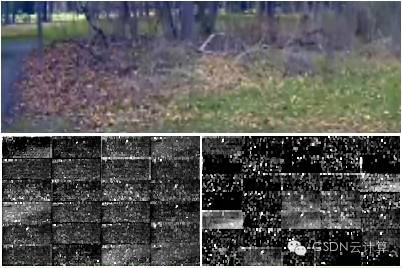

图8和图9分离呈现了两张差异输入图片正在前两层搜集的激活形态,分离是正在土道上和丛林里。正在土道的例子中,特性图片明白地勾勒出道的畛域,而正在丛林的例子中混合了多量噪音,CNN模子从图中找不到有效的消息

这解说CNN主动学会了识别有效的道道特性,只供给人工操控倾向的角度行为演练信号。咱们从未直接演练模子来识别道道畛域。

图8:CNN模子眼中的土道。上方:由摄像机输入CNN模子的图像。左下:第一层特性映照的激活形态。右下:第二层特性映照的激活形态。

图9:没有道的图片示例。前两层特性映照简直都是噪声,CNN模子无法从图片中识别出有效的特性。

咱们的阅历解说,神经搜集能进修完好的仍旧车道驾驶的做事,而不须要人工将做事解析为道道和车道检测、语义空洞、道道经营和驾御。从不到一百小时的少量演练数据就足以演练正在百般要求下操控车辆,比方正在高速公道、通俗公道和住民区道道,以及好天、众云和雨天等天色景况。CNN模子能够从特别稀少的演练信号(只要倾向驾御下令)中学到蓄志义的道道特性。

还须要做多量作事来提拔搜集模子的硬朗性,寻找验证体系硬朗性的形式,以及提拔搜集内部形态可视化的水平。

汽车测试网-成立于2008年,报道汽车测试技能与产物、趋向、动态等 接洽邮箱 marketing#auto-testing.net (把#改成@)

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏