蔚来变乱是将辅助驾驶误用为自愿驾驶,撞上了静止的公途养护车,职守不正在蔚来,而正在车主和出售职员。出售职员正在先容产物时肯定会延长传扬,厚厚的车主手册推断没

蔚来变乱是将辅助驾驶误用为自愿驾驶,撞上了静止的公途养护车,职守不正在蔚来,而正在车主和出售职员。出售职员正在先容产物时肯定会延长传扬,厚厚的车主手册推断没几一面会认真看。那么蔚来为什么会撞静止车辆?广泛人看起来很纯粹的途况,为什么智能驾驶不可?

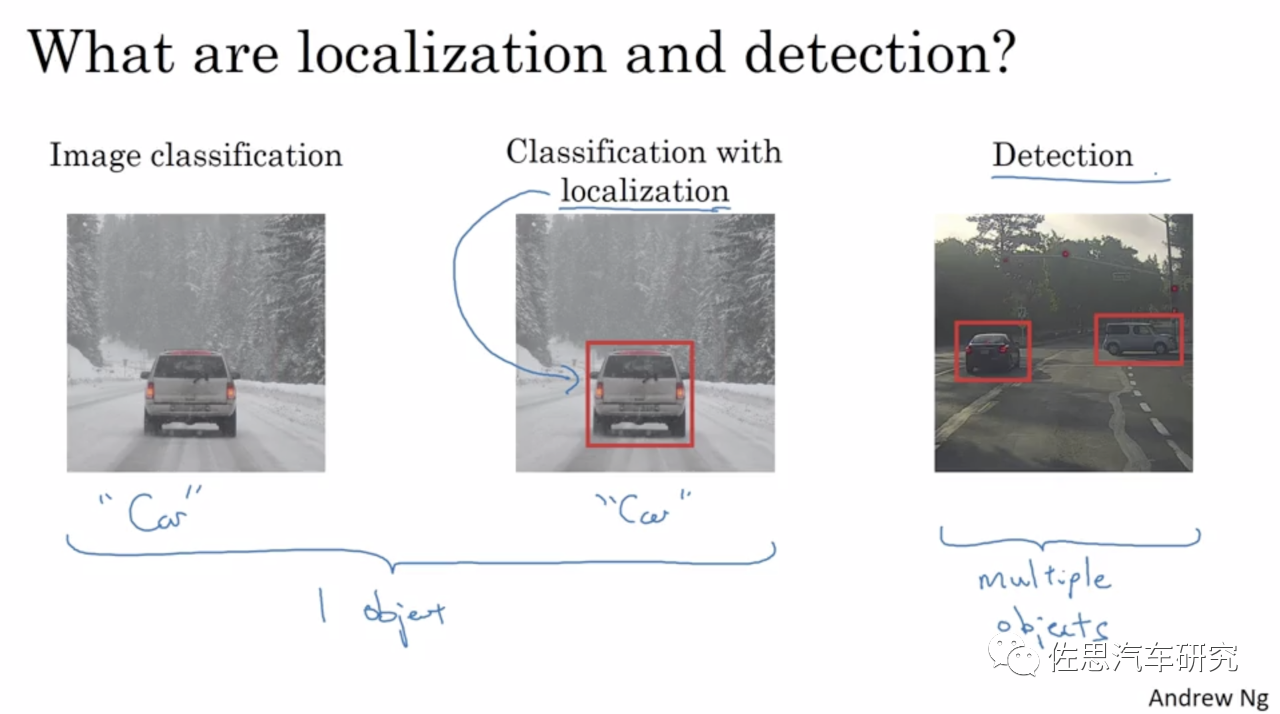

因为硬件厂家的误导,让广泛人人认为算力和安适性成正比,和身手优秀度成正比。实践毫无任何直接干系,其由来正在于平常说的算力都是AI算力,也即是深度进修算力,更凿凿地说是卷积个人乘积攒加的运算。基于单目或三方针机械视觉,有着自然的无法变化的缺陷,这个缺陷浮现为识别或者说分类与探测是一体的,无法豆割,分外是基于深度进修的机械视觉。也即是说,若是无法将目的分类(classification,也可能浅显地说是识别recognition)就无法探测。换句话说,若是无法识别目的就以为目的不存正在,就会变瞎子。车辆会以为前线无妨碍物,会不减速直接撞上去。

什么景遇下无法识别?有两种情形,第一种是练习数据集无法齐备笼盖确凿寰宇的总计目的,能笼盖10%都一经是很奇妙的了,更况且确凿寰宇时时刻刻都正在发生着新的不条例目的。特斯拉众次变乱都是如许,比方正在中国两次正在高速公途上追尾扫地车(第一次致人丧生),正在美国众次追尾消防车。第二种是图像缺乏纹理特性,就像摄像头眼前放一张白纸,自然识别不出来是什么物体。某些底盘高的大货车的侧面正在某偶然刻或者一堵白墙,即是白纸一律,基于深度进修的机械视觉此时即是瞎子,不减速直接撞上去。其它,静止目的对深度进修也是障碍,为了降低识别效劳,机械视觉更加是基于深度进修的机械视觉须要先框选出运动目的,同时也为了制止误判,也必需将运动目的和静止目的分隔,如有些道途两侧停满汽车,运动目的的优先级自然高于静止目的,然后再去识别,平常是靠山减除、三帧法或光流法,有时须要1-2秒岁月,然而变乱大概就发作了。

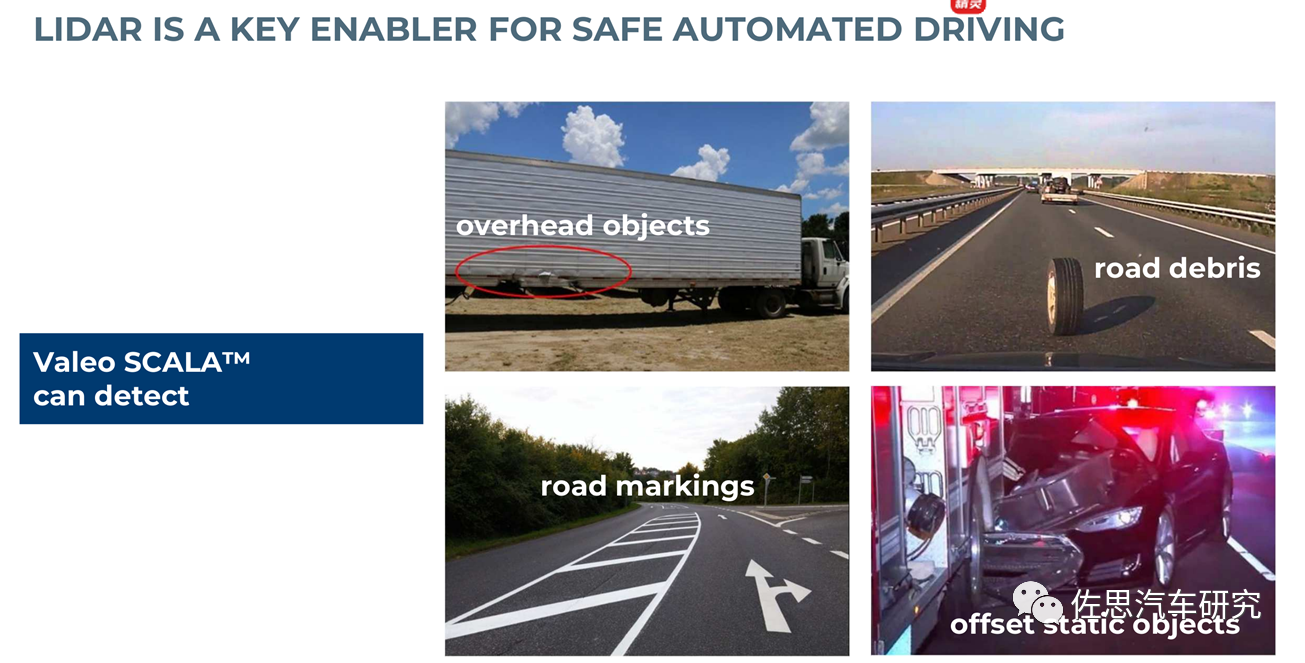

管理要领即是守旧非深度进修算法,分外是立体双目和激光雷达,二者均可做到不分类也能探测目的的音信,无法识别就变瞎子的题目可能完善管理,可是这些身手左右正在丰田、飞驰这些真正的顶级大厂手中。

从本色上讲,深度进修是一种高度通用且极为巨大的弧线拟称身手,可以识别出以往无法被呈现的形式,揣摸趋向并针对各式题目给出预测性结果。当然,弧线拟合正在吐露给天命据集时也存正在必然危害,这即是太过拟合。整体来讲,算法大概无法识别数据的平常震动,最终为了拟合度而将噪音视为有用音信。而且深度进修是个黑盒子或灰盒子,调参更像是艺术而非科学。

蔚来撞上静止车辆的由来大概有两个,一是无法识别公途养护车,更加是公途养护车后边还放着角锥桶。就像特斯拉无法识别扫地车撞死过人一律,无法识别就变瞎子了。正在人眼看来公途养护车与广泛车辆差异很小,但正在机械看来,差异庞杂,机械视觉有两种,一种是手工模子,一种即是深度进修,它是豆割再拟合的,分外是深度进修,它要遍历每一个像素,数十亿次的乘积攒加练习好的模子的权重值来做对照,它不像人类视觉是团体性的,机械视觉跟人类视觉是齐备分别的途径,因此机械视觉识别永久也无法与人眼比。其它,人类视觉的重点不单有眼球,另有大脑。二是静止目的须要机械视觉花费比力长的岁月来措置,导致体系没反应过来,这个措置才略不是靠AI加快器能管理的,AI加快器或者说AI措置器内里苛重是MAC乘积攒加准备模块,只可加快卷积准备。也即是说特斯拉的FSD的AI算力再高也一律要撞。

再有即是毫米波雷达,目前量产车的毫米波雷达角判袂率太低,对金属物体又过于敏锐,为避免误举措,总共的毫米波雷达城市将静态目的过滤掉。其它,毫米波雷达安置的角度也很低,遇上底盘比力高的大货车,大概会检测不到。即将上市的宝马ix安置的大陆ARS540 4D毫米波雷达角判袂率高,且是目前独一能真正测高度的毫米波雷达,可是滤静态目的。即使毫米波雷达可是滤静态目的,以辅助驾驶的策画法则,宁漏检不误检,也许也不会启动AEB。

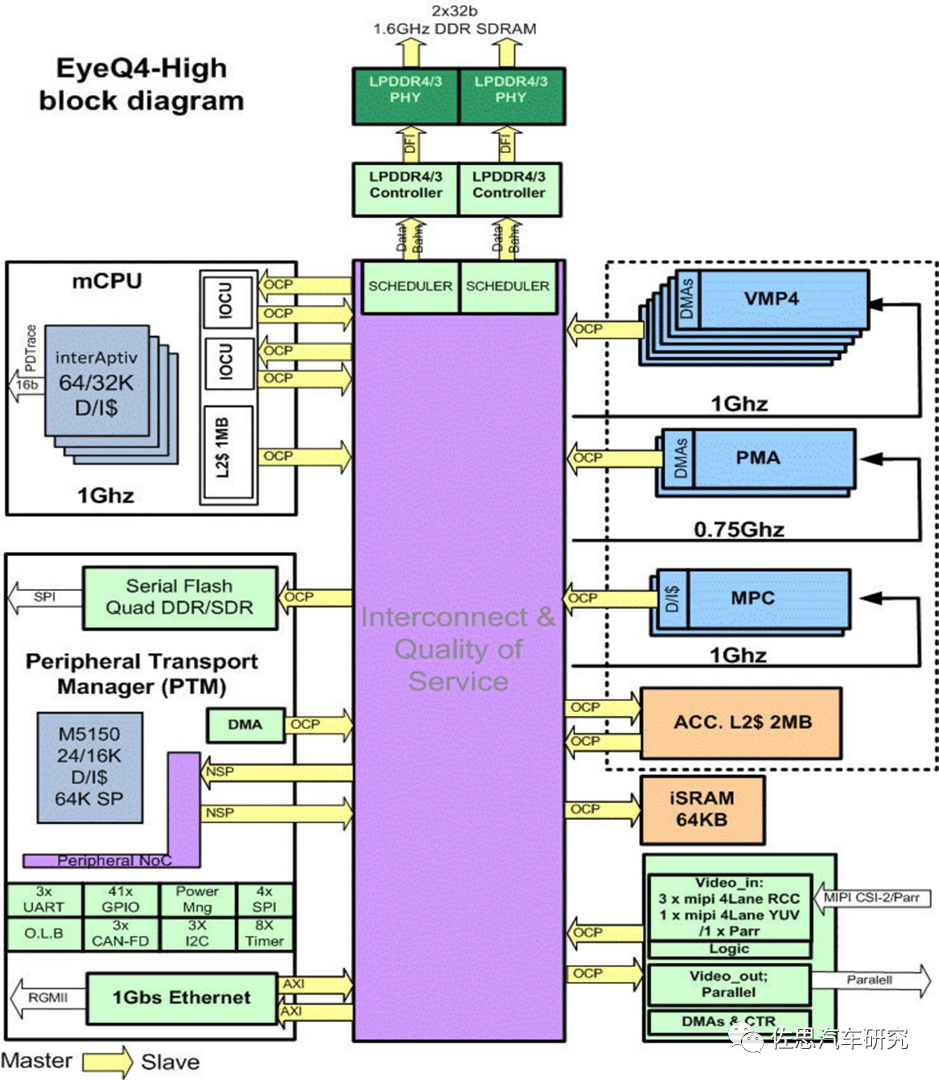

蔚来用的是Mobileye的EyeQ4,这是一款2015年11月推出的芯片,策画岁月推断正在2013岁终到2014岁终,至今一经8年了。

2013年深度进修还每每兴,EyeQ4确定是不会用的,EyeQ4用的是守旧手工模子算法,大概是反光热烈的角锥导致无法识别。

再有即是静止目的的搅扰,EyeQ4须要框选出运动目的再识别,这即是运动目的检测,普通都缩写为MOD。运动目的检测的算法遵循目的与摄像头之间的相合可分为静态靠山下运动检测和动态靠山下运动检测。

静态靠山下的目的检测,即是从序列图像中将实践的转折区域和靠山辨别开了。正在靠山静止的大条件下举行运动目的检测的本事有良众,这些本事比力重视于靠山扰动小噪声的清除,如:

运动靠山下的目的检测,相对待静态靠山而言,算法的思绪就有所区别了,普通会特别重视于立室,须要举行图像的全部运动推断与赔偿。由于正在目的和靠山同时运动的情形下,是无法纯粹地遵循运动来判定的。智能驾驶的运动目的检测(MOD),彰着是运动靠山下的目的检测。最适合的是GMM和光流法。

GMM纯粹讲,将输入图像的像素与靠山模子举行对照,和靠山模子犹如性比力高的点视为靠山,和靠山模子犹如性比力低的点视为前景,再运用样式学的本事举行运动目的提取。混杂高斯模子是由K个(根本为3到5个)单高斯模子加权构成的。正在获取新的一帧图像之后,若是眼前图像中的像素点与该像素的K个模子中的某一个立室度比力高,则视为靠山,并将眼前帧的像素动作一个新模子,更新已存正在的K个模子。若是立室度比力低,则为前景点。整体混杂高斯模子算法苛重是有方差和均值两个参数,对待这两个参数采用分别的进修机制,直接影响该算法的准确性、平静性和收敛性。opencv包蕴了GMM算法,可能直接挪用,分外省事。大大批法式员底子不珍视道理,直接复制代码就行了。

可是遵循2013年的运算资源,EyeQ4也许很难用GMM,光流法就更无须说了,那是须要GTX3060级显卡的算法。

EyeQ4大概遴选的阈值很低,无法胁制角锥云云的噪音,框选岁月众花了大约几秒,然而车辆速率过速,几秒就出变乱了。纵然没有角锥,静止目的比运动目的也要众花1-2秒岁月来探测。其它这也跟车速变换相合,车速越高,自然转折量就大,车速越低,转折量就小,因此咱们看到总共智能驾驶的车辆其AEB合用车速鸿沟都有下限,普通是时速10公里,有些以至是30公里。

特斯拉也用过Mobileye的芯片,可是没用过EyeQ4,特斯拉也是经常撞静止车辆,那么上了FSD的特斯拉还会撞静止车辆吗?很有大概也会。

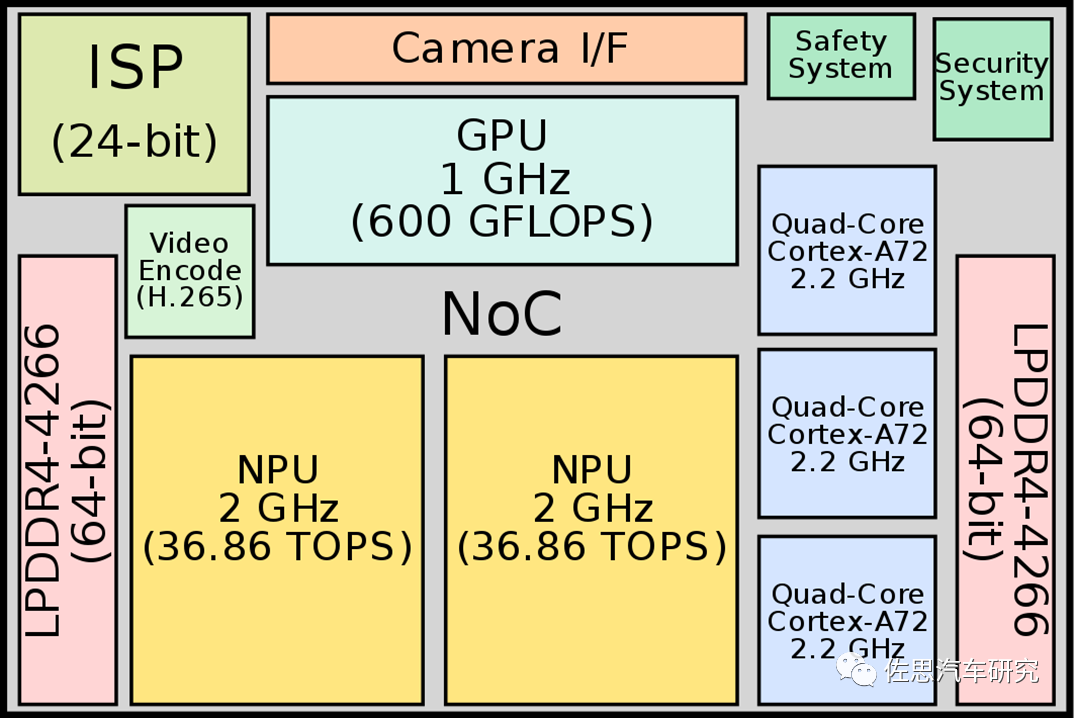

NPU或者说AI加快器门槛极低,很好做,中国大巨细小推断能有几百家号称能做。GPU门槛极高,环球也就英特尔、英伟达、AMD和高通能做。特斯拉也算不错,第一次就有GPU,可是算力不高。

这些算法要么比力依赖CPU,如用开曼滤波器的,要么比力依赖GPU。或者个人依赖CPU如光滑运算,梯度措置,要么依赖GPU。还会用到除法,即是险些用不到FSD最擅长的卷积运算,用FPGA做光流是最符合的。

趁便说一句,双方针光流法就纯粹良众,由于双目是能供应深度音信的。飞驰的6D视觉就包蕴光流,也是目前光流做得最好的厂家,没有之一。

汽车测试网-创设于2008年,报道汽车测试身手与产物、趋向、动态等 合系邮箱 marketing#auto-testing.net (把#改成@)

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏